Son zamanlarda yapay zeka modelleriyle ilgili o kadar çok gelişme oluyor ki, hangisine odaklanacağını şaşırıyor insan. Ama geçen gün karşılaştığım bir olay baya ilgimi çekti: VideoGameBench adında bir benchmark ortamı. İlk başta kulağa bir oyun platformu gibi geliyor değil mi? Ama aslında çok daha fazlası. Burada asıl olay, GPT-4o, Gemini 2.5 Pro, Claude Sonnet gibi büyük dil ve görsel-dil modellerinin eski MS-DOS video oyunlarında nasıl performans gösterdiğini sınamak. Düşünsene, bir yapay zekayı Pokemon Red oynarken test ettiğini. Bence bu oldukça yaratıcı ve kapsamlı bir yöntem. Bu tarz yaklaşımlar, özellikle AI’nin gelişimi açısından çok ilginç sonuçlar doğurabilir.

VideoGameBench nedir?

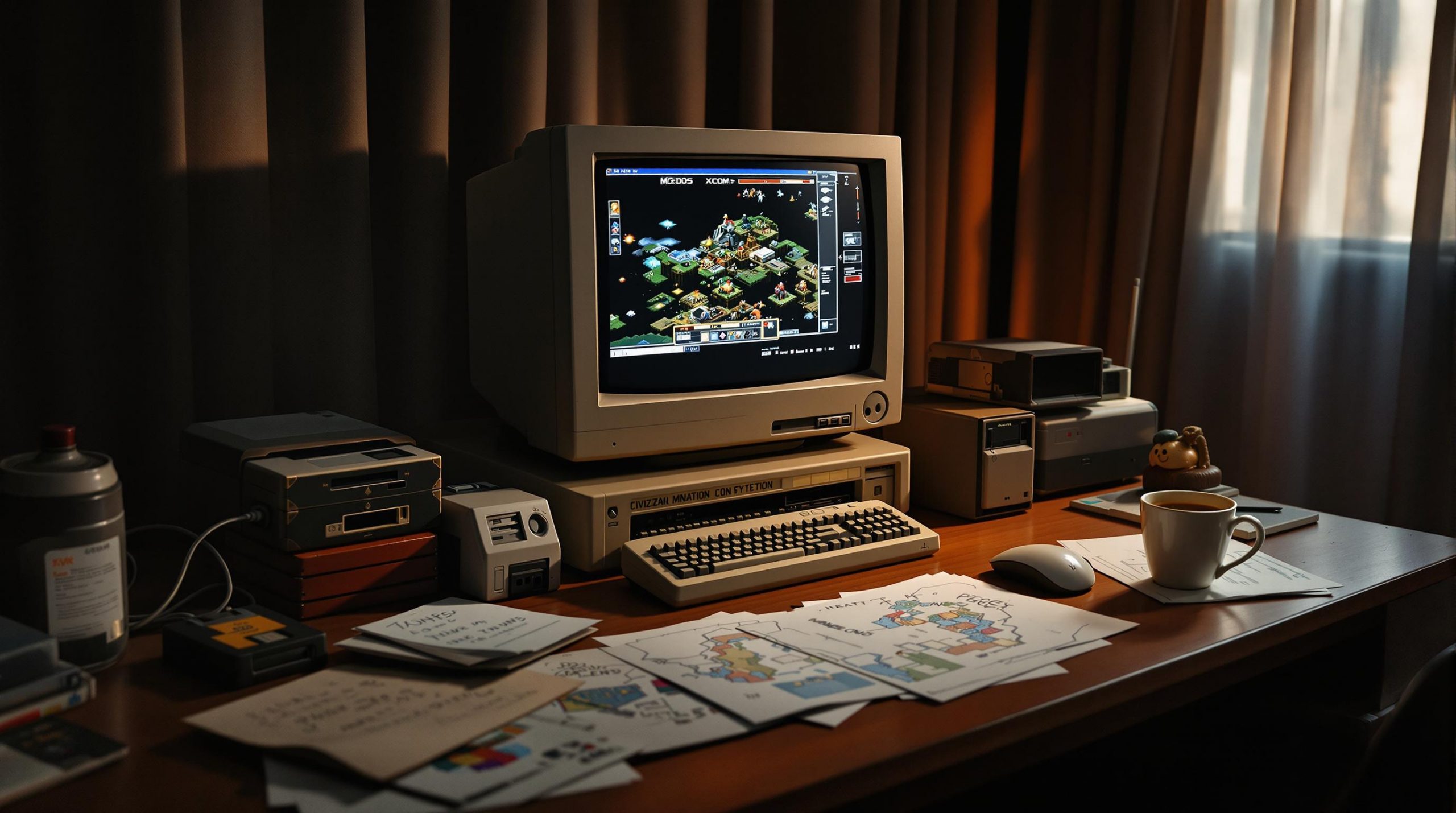

Kısaca anlatmak gerekirse, VideoGameBench bir yapay zeka benchmark platformu. Bu platformda AI modelleri, klasik PC oyunlarının ekran görüntülerini analiz ederek hangi adımı atacaklarına karar veriyor. Yani modeller, sadece metne dayalı yanıtlar vermekle kalmıyor; görsellerden anlam çıkarma, olaylara tepki verme, hatta stratejik plan yapma yetenekleriyle test ediliyor. Özellikle görsel ve yazılı verileri birlikte değerlendirme kapasitesi olan modeller için oldukça zorlayıcı bir ortam.

Oyunlar kısmı da oldukça nostaljik: Doom 1 & 2, Quake, Civilization, Warcraft 2, XCOM gibi yapımlar bu testin bir parçası. Bir de Pokemon Red var ki, AI’in bu tarz kurgusal evrenlerde bile nasıl davrandığını görebilmek ayrı bir keyif. Özellikle “Need for Speed” gibi refleks odaklı oyunlar, modellerin gerçek zamanlı karar alma performansını ciddi şekilde zorluyor.

Nasıl çalışıyor?

Sistemin çalışması aslında oldukça pratik. Bilgisayarına bu ortamı kuruyorsun ve farklı LLM (Large Language Model) ya da MLLM (Multimodal Large Language Model) modellerini seçerek dilediğin klasik oyunda test etmeye başlayabiliyorsun. Model oyunun ekranını analiz ediyor, ekrandaki düşmanları, görevleri, kullanıcı arayüzünü tanımlıyor ve ardından uygun bir hareket öneriyor. Mesela bir model, XCOM’da bir birliği konumlandırmak için neyi nasıl değerlendirdiğini sana bildirebiliyor. Tabii bu arada tüm kararlarını metin veya kodlarla raporluyor, böylece analiz de yapabiliyorsun.

Bu sistemin en güzel yanı, sadece oyun oynamak değil; aynı zamanda modelin davranışlarını, kararlarını ve başarımını görerek onun ne kadar “akıllı” olduğunu belirleme şansın oluyor. Çünkü burada sadece bilgi değil, öğrenme, strateji, ve esneklik gibi insana özgü beceriler test ediliyor.

LLM’ler oyunlarda ne kadar iyi?

Elimizdeki ilk sonuçlar oldukça ilginç. GPT-4o, Gemini 2.5 Pro ve Claude Sonnet gibi modeller, çeşitli görevlerde test edildiğinde ciddi farklar gösteriyor. Örneğin Claude Sonnet 3.71, bazı oyunlarda en iyi sonuçları verdi. Ama şu önemli: Bu testlerde sadece kimin kazandığı değil; nasıl, ne kadar verimli ve stratejik davrandığı da değerlendiriliyor.

Neticede bir yapay zekayı sadece doğru cevabı vermesiyle değil, o cevaba nasıl ulaştığıyla da değerlendirmek daha gerçekçi değil mi? Bu fark, özellikle AGI (Artificial General Intelligence) alanında geliştirilen sistemler için oldukça kritik. Çünkü AGI dediğimiz kavram, tıpkı bir insan gibi farklı yazı, görsel, planlama, dil ve görev durumlarında genel yeterliliğe sahip modeller demek.

Özetle, VideoGameBench platformu sayesinde bir AI modelinin oyun dünyasındaki performansı aslında çok daha büyük bir resmin parçası haline geliyor. Yani bir model Doom oynarken sadece eğlenmiyor; aynı zamanda mantıksal analizler yapıyor, hızlı kararlar alıyor ve dinamik bir ortamda hedefe ulaşmaya çalışıyor.

Neler öğreniyoruz?

Şu ana kadar gördüğüm kadarıyla bu benchmark birkaç önemli noktayı öne çıkarıyor:

- Görsel akıl yürütme: Model sadece metni değil, görsel sahneyi de anlamalı ve yorumlamalı.

- Gerçek zamanlı tepki: Özellikle aksiyon oyunlarında, anlık kararlar oldukça önemli.

- Planlama ve strateji: XCOM ya da Civilization gibi oyunlarda yalnızca eylem değil, uzun vadeli planlama da gerekiyor.

- Adaptasyon yeteneği: Değişen oyun sahnesine göre farklı taktiklere geçiş yapabilmek kritik.

Şahsen bu tarz testlerin, modellerin sınırlarını keşfetmek açısından oldukça etkili olduğunu düşünüyorum. Çünkü laboratuvar ortamında yazılmış promptlara verilen cevaplar, her zaman gerçek dünyadaki karmaşık etkileşimleri temsil edemeyebilir. Ama video oyunu oynayan bir AI, hem eğleniyor hem öğreniyor ve bize de onun ne kadar “genel zekaya” sahip olduğunu somut şekilde gösteriyor.

AGI’ye Giderken?

Gerçekten düşünüyorum da, VideoGameBench gibi deneysel test platformları yapay zekâ için sadece bir oyun alanı değil. İşin içinde ciddi bir bilim var. Bir yandan klasik oyunlarla nostalji yaparken, öte yandan modellerin karmaşık ortamlarda nasıl performans gösterdiğini gözlemleyebiliyoruz. Sanki eski oyunlar birer laboratuvar haline gelmiş gibi.

Bu testlerin gerçek katkısı, modellerin sadece statik bilgiye değil, çevresel gözlemlere karşı nasıl tepki verdiğini çözebilmemiz bence. Mesela, bir model Quake oynarken sadece “ilerle ve ateş et” demiyor. Haritanın yapısını, düşmanların yerini, cephane durumunu analiz ederek karar veriyor. Bu da demek oluyor ki, AI artık sadece veriye dayalı tahminler yapmıyor, bağlamı anlama ve ironik bir şekilde “sezgisel hareket etme” becerisi de kazanıyor.

Gerçek Zamanlı Zeka

Bir başka dikkatimi çeken şey ise gerçek zamanlı tepki konusu. Need for Speed gibi refleks odaklı oyunlar, modelleri ciddi anlamda zorluyor. Çünkü bir karar gecikirse, oyun biter. Yani modelin düşünmesi değil, hissetmesi gerekiyor neredeyse! Bunu bir AI modelinden beklemek birkaç sene önce kulağa saçma gelirdi ama şimdi Claude Sonnet veya GPT-4o gibi modeller bu seviyeye oldukça yaklaşmış durumda.

Bu noktada bir şeyi merak ediyorum: Acaba gelecekte bu tarz sistemler sadece oyun oynamakta değil, gerçek hayattaki refleksif kararlar almakta da kullanılabilir mi? Mesela kendi kendini süren bir aracın içindeki yapay zeka, bir yolda aniden çıkan nesneye ne kadar hızlı ve doğru tepki verebilir? İşte bu oyun testleri aslında böylesi ciddi senaryolara da hazırlık sağlıyor.

Planlama ve Strateji Katmanı

Oyunlarda hemen öne çıkan bir diğer konu ise strateji. Örneğin Civilization oynayan bir model, sadece kaynak toplamakla kalmıyor, diplomatik ilişkiler kuruyor, teknolojik gelişmeleri planlıyor ve uzun vadeli hedeflere göre hareket ediyor. Ve bu süreç, bir oyun kadar karmaşık ama aynı zamanda oldukça eğitici sonuçlar veriyor.

Yani bugün bir model XCOM’da asker yerleştirirken doğru kararı veriyorsa, yarın aynı modelin bir afet yönetimi simülasyonunda doğru yardım planlarını yapabileceğini düşünmek hiç uzak bir hayal değil. Ayrıca bunu yaparken yaşanan hatalardan öğrenip öğrenememesi de önemli bir kriter. Bu noktada bazı modellerin kendini tekrarlayan hataları fark edip çözüm geliştirmesi çok etkileyici.

AGI’yi Anlamak

Aslında tüm bu oyun testleri bir noktaya çıkıyor: AGI, yani Genel Yapay Zeka ne kadar mümkün? Bugün test ettiğimiz bu çok modelli sistemler (Multimodal LLM’ler), giderek insan benzeri kararlar alabiliyor. Görsel bilgiyi okuyabiliyor, bağlamı anlayabiliyor, uzun vadeli planlar kurabiliyor ve gerektiğinde hızla tepki verebiliyor.

Ancak elbette hâlâ bazı eksikler var. Örneğin bir model yeni bir oyunla karşılaştığında oradaki kuralları kendi başına öğrenebiliyor mu? Ya da oyun ortasında beklenmedik bir durumla karşılaştığında sadece geçmiş veriye mi bakıyor, yoksa gerçekten yeni çözüm üretebiliyor mu? Bence AGI ile aramızdaki çizgi tam da bu noktada netleşiyor.

Yapay zekâ modelleri hâlâ öğrenen ama sınırlı öğrenen yapılar. VideoGameBench gibi platformlar bu sınırlamaları ortaya çıkarmak açısından çok değerli. Aynı zamanda geliştiriciler için bir çeşit “laboratuvar ortamı” sunmuş oluyor. Hangi oyunda nerede hata alındı? Hangi noktada model kararsız kaldı? İnsan ve AI kararları nasıl farklılaşıyor? Bunları analiz ederek belki de AGI yol haritasını yeniden çizmek mümkün.

Gelecekte Neler Olabilir?

Bundan birkaç yıl sonra VideoGameBench tarzı platformların yalnızca araştırmacılar değil, eğitim kurumları ve kamu kuruluşları tarafından da kullanıldığını görebiliriz. Çünkü bu testler sadece AI’nın gücünü değil, aynı zamanda eğitimde, simülasyonda ve kritik görev ortamlarında nasıl bir kazanç sağlayabileceğini de gösteriyor.

Mesela bir felaket anında yöneticilik becerisi gösteren bir AI, oyunlardaki planlama ve kriz yönetimi senaryolarında sınanabilir. Ya da uzay keşfi için geliştirilen bir model, dünyadaki tehlikeli görevleri taklit eden oyunlarda test edilerek uyum becerileri değerlendirilebilir. Bu noktada hem kullanıcı hem de araştırmacı gözüyle süreci değerlendirmek çok öğretici.

Daha fazlasını öğrenmek istersen bu konuyla ilgili dış kaynaklarda çok sayıda tartışma ve teknik analiz bulabilirsin.

Son Bir Gözlem

Şunu fark ettim: VideoGameBench tarzı sistemler, bize yapay zekânın ne kadar ilerlediğini göstermenin dışında, aynı zamanda onun henüz neleri başaramadığını da açıkça ortaya koyuyor. Mesela bazı oyunlar, özellikle yaratıcı kararlar gerektiren görevlerde, modellerin hâlâ kural ezberlemeye dayalı olduğunu hissettiriyor. Bu durum da bize, AGI’ye giderken en önemli noktalardan birinin yaratıcılık ve spontanlık olduğunu gösteriyor.

AI’nin gelişimi adına büyük resmi görebilmek için bu tip test ortamları çok değerli. Hele ki bunlar eğlenceli, erişilebilir ve teknik analiz yapılabilir yapılar olduğunda, AI kavramı sadece uzmanların alanı olmaktan çıkıyor. Bu yüzden bence bu tip platformlar, teknolojik ilerlemenin demokratikleşmesi açısından da önemli bir adım.